Автор — Отем Спредеманн, The Epoch Times (выделено нами),

Учёные и специалисты по кибербезопасности предупреждают, что волна фальшивых научных исследований, созданных с помощью искусственного интеллекта (ИИ), незаметно просачивается сквозь проверки на плагиат и попадает в научные архивы. Это явление ставит под угрозу будущую достоверность научных исследований, усиливая давнюю индустрию мошенничества, основанную на «бумажной фабрике», утверждают эксперты.

Академические бумажные фабрики — фиктивные организации, получающие прибыль от фальсификации исследований и авторства — годами досаждали ученым, а теперь ИИ выступает в роли умножителя силы.

Некоторые эксперты полагают, что для решения этой проблемы необходимы структурные изменения, а не только улучшение системы проверки на плагиат.

Масштабы проблемы ошеломляют: по данным Nature Portfolio, в 2023 году по всему миру было отозвано более 10 000 исследовательских работ.

По данным Университета Буроса , рукописи, созданные с использованием больших языковых моделей (LLM), распространяются по различным академическим дисциплинам и платформам, включая Google Scholar . Недавний анализ, опубликованный в журнале Nature Portfolio, показал, что инструменты LLM, такие как ChatGPT, Gemini и Claude, могут создавать правдоподобные исследования, проходящие стандартную проверку на плагиат.

В мае Диомидис Спинеллис, преподаватель компьютерных наук и профессор Афинского университета экономики и бизнеса, опубликовал независимое исследование контента, созданного с помощью ИИ, в журнале Global International Journal of Innovative Research после того, как обнаружилось, что его имя было использовано в ложной атрибуции.

Спинеллис отметил, что только пять из 53 изученных статей с наименьшим количеством внутритекстовых ссылок имели признаки человеческого участия. Результаты обнаружения ИИ подтвердили «высокую вероятность» наличия контента, созданного ИИ, в оставшихся 48 статьях.

В ходе анализа «мусорной» научной литературы, опубликованной в Google Scholar и созданной с помощью ИИ, исследователи из шведского университета выявили более 100 статей, предположительно созданных с помощью ИИ.

Google не отреагировала на просьбу The Epoch Times прокомментировать ситуацию.

Авторы шведского исследования заявили, что основная проблема исследований, проводимых с помощью ИИ (независимо от того, проводится ли это с помощью человека), заключается в том, что дезинформация может быть использована для «стратегического манипулирования».

«Риск того, что мы называем „взломом доказательств“, значительно возрастает, когда результаты исследований, созданных с помощью ИИ, распространяются в поисковых системах. Это может иметь ощутимые последствия, поскольку неверные результаты могут проникнуть глубже в общество и, возможно, во всё большее число областей», — заявил автор исследования Бьёрн Экстрём.

Более того, команда шведского университета считает, что даже если статьи будут отозваны, работы по ИИ создадут нагрузку на и без того перегруженную систему рецензирования.

Далеко идущие последствия

«Наиболее разрушительные последствия потока ненужной научной информации, созданной ИИ, будут ощущаться в областях исследований, которые касаются людей», — рассказал изданию The Epoch Times Нишанши Шукла, специалист по этике ИИ из Университета Вестерн-Гавернорс.

Шукла отметил, что при использовании ИИ для анализа данных решающее значение имеют человеческий контроль и анализ.

« Когда все исследования проводятся с помощью ИИ, возникает риск гомогенизации знаний », — сказала она.

«В ближайшей перспективе это означает, что все исследования, [которые] следуют схожим путям и методам, искажены схожими предположениями и предубеждениями и ориентированы только на определённые группы людей», — сказала она. «В долгосрочной перспективе это означает отсутствие новых знаний, а их производство — циклический процесс, лишённый человеческого критического мышления».

Михал Привата, соучредитель компании Vertus, занимающейся исследованиями в области искусственного интеллекта, согласен, что тенденция к фальшивой науке в сфере искусственного интеллекта является проблематичной, и ее последствия уже заметны.

« По сути, то, что мы сейчас наблюдаем, эквивалентно атаке типа «отказ в обслуживании». Настоящие исследователи тонут в шуме, рецензенты перегружены, а цитаты засоряются сфабрикованными ссылками. Это затрудняет выявление и подтверждение подлинного научного прогресса », — заявил Привата изданию The Epoch Times.

Работая с передовыми системами искусственного интеллекта, Прайвата вблизи наблюдал побочные продукты массового развертывания LLM, которые, по его мнению, и являются сутью проблемы.

«Это предсказуемое следствие отношения к ИИ как к инструменту повышения производительности, а не к пониманию того, что такое интеллект на самом деле», — сказал он. «Степень магистра права (LLM) в её нынешнем виде не устроена подобно разуму. Это сложные системы сопоставления шаблонов, которые невероятно хороши в создании правдоподобно звучащих текстов, и именно это нужно фальшивым исследованиям, чтобы выглядеть убедительными».

Директор по информационной безопасности компании Optiv Натан Венцлер считает, что на карту поставлено будущее общественного доверия.

« Поскольку в уважаемые журналы и ключевые научные обзоры добавляется все больше некорректного или откровенно ложного контента, созданного ИИ, краткосрочные и долгосрочные последствия остаются теми же: подрыв доверия », — сказал Венцлер изданию The Epoch Times.

Венцлер отметил, что с точки зрения безопасности университеты теперь сталкиваются с другой угрозой, когда речь идет о краже интеллектуальной собственности.

«Мы стали свидетелями кибератак со стороны государственных структур, целью которых была кража результатов исследований из университетов и научно-исследовательских институтов, а затем эти же самые государства развернулись и опубликовали результаты исследований своих собственных университетов, как будто они сами провели эти исследования», — сказал он.

В конечном итоге, по словам Венцлера, это может иметь огромные финансовые последствия для организаций, рассчитывающих на гранты для развития законных научных исследований, технологий, здравоохранения и многого другого.

Венцлер описал возможный пример из реальной жизни: «ИИ можно легко использовать для усиления этих кибератак, изменения содержания украденного исследования ровно настолько, чтобы создать иллюзию того, что это уникальный и отдельный контент, или создания ложного представления о том, что существующее исследование ошибочно, путем создания фальшивых контрапунктических данных, чтобы подорвать доверие к исходным данным и выводам.

« Потенциальные финансовые последствия огромны, но неизмеримо то, как они могут повлиять на достижения, приносящие пользу людям по всему миру », — сказал он.

Привата отметил, что значительная часть общественности уже подвергает сомнению деятельность академических кругов.

«Меня пугает то, что это заставит людей сомневаться в научных учреждениях», — сказал он. «Теперь у людей есть доказательства того, что систему можно масштабно обмануть. Я бы сказал, что это опасно для общества».

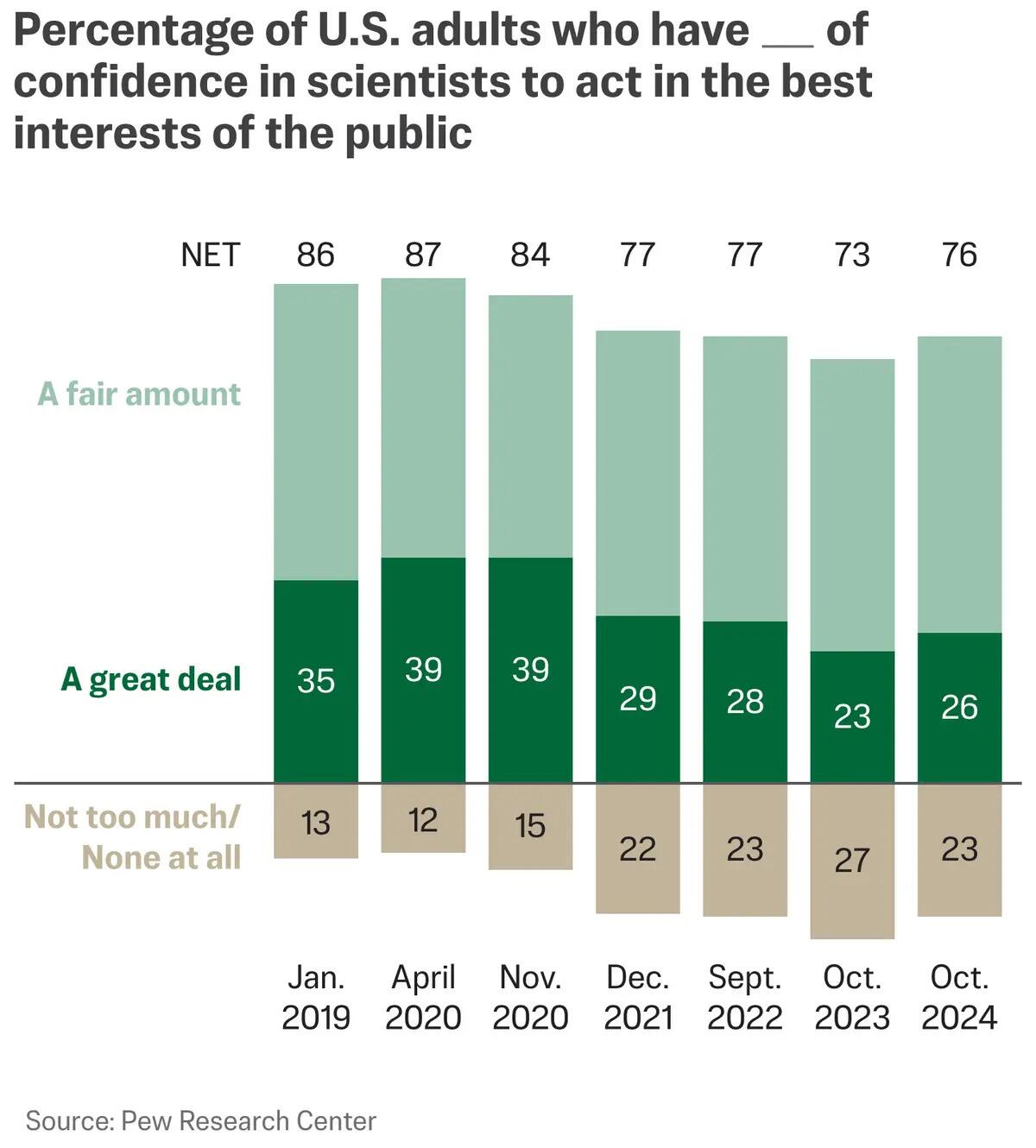

Поток фейковых исследовательских работ, созданных с помощью ИИ, происходит в то время, когда общественное доверие к науке остаётся ниже, чем до пандемии COVID-19. Анализ , проведённый Pew Research Center в 2024 году , показал, что лишь 26% респондентов в значительной степени уверены в том, что учёные действуют в интересах общества. 51% заявили о своей достаточной уверенности; для сравнения, в 2020 году число респондентов, выразивших такой же уровень доверия к науке, составило 87%.

В то же время американцы стали относиться с недоверием к достижениям в области искусственного интеллекта. Недавнее исследование Института Брукингса показало, что участники, получившие информацию о достижениях в области искусственного интеллекта, стали относиться к ним с недоверием по различным показателям, включая лингвистику, медицину и знакомства, по сравнению с достижениями в тех же областях, не связанными с искусственным интеллектом.

Продолжение читайте здесь...

Комментариев нет:

Отправить комментарий