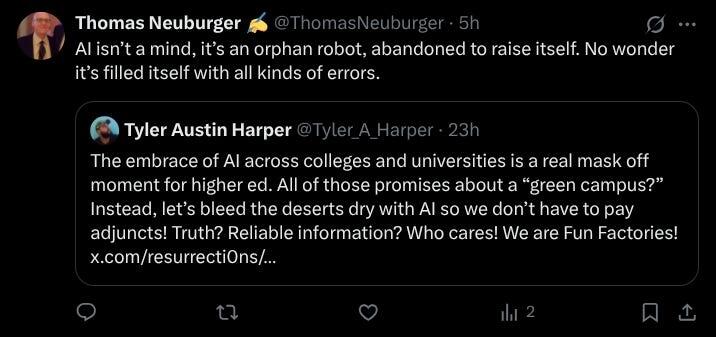

Автор Томас Нойбегер через Substack "Шпионы Бога",

ИИ не может решить проблему, которую ранее не решал человек.

- Арно Бертран

Об ИИ можно сказать многое, но итоговых данных мало. Рассмотрим мои последние слова по самой теме. (О его злоупотреблении со стороны государства национальной безопасности я расскажу подробнее позже.)

Искусственный интеллект монстров

ИИ не принесет ничего, кроме вреда. Как я уже говорил ранее, ИИ — это не просто катастрофа для нашего политического здоровья, хотя да, будет так (ищите линию Кэдвалладера “построение техноавторитарного государства наблюдения”). Но ИИ — это также катастрофа для климата. Это ускорит крах десятилетиями по мере расширения использования.

(См. видео beow почему модели ИИ — огромные пожиратели энергии. Смотреть это видео чтобы понять сами “нейронные сети”.)

Почему ИИ не остановят? Потому что гонка за ИИ на самом деле не гонка за технологиями. Это гонка за деньгами, во многом движимая жадностью. Нашей жизнью уже управляют те, кто ищет денег, особенно те, у кого их и так слишком много. Теперь они нашли способ прокормить себя еще быстрее: убедив людей сделать это простой поиск с помощью ИИ, а пожирающая газ машина смерти.

По обеим этим причинам — массовое наблюдение и климатическая катастрофа — ИИ не принесет никакой пользы. Ни одной унции.

Робот-сирота, брошенный, чтобы вырастить себя

Почему ИИ продолжает совершать ошибки? Я предлагаю один ответ ниже.

ИИ не думает. Вместо этого он делает что-то другое. Полное объяснение читайте дальше.

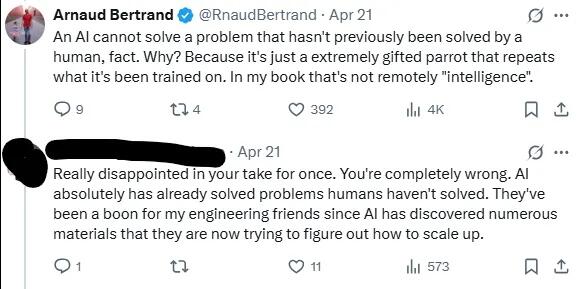

Arnaud Bertrand on AI

Arnaud Bertrand has the best explanation of what AI is at its core. It’s not a thinking machine, and its output’s not thought. It’s actually the opposite of thought — it’s what you get from a Freshman who hasn’t studied, but learned a few words instead and is using them to sound smart. If the student succeeds, you don’t call it thought, just a good emulation.

Since Bertrand has put the following text on Twitter, I’ll print it in full. The expanded version is a paid post at his Substack site. Bottom line: He’s exactly right. (In the title below, AGI means Artificial General Intelligence, the next step up from AI.)

Apple just killed the AGI myth

The hidden costs of humanity's most expensive delusion

by Arnaud Bertrand

About 2 months ago I was having an argument on Twitter with someone telling me they were “really disappointed with my take“ and that I was “completely wrong“ for saying that AI was “just a extremely gifted parrot that repeats what it's been trained on“ and that this wasn’t remotely intelligence.

Fast forward to today and the argument is now authoritatively settled: I was right, yeah! 🎉

How so? It was settled by none other than Apple, specifically their Machine Learning Research department, in a seminal research paper entitled “The Illusion of Thinking: Understanding the Strengths and Limitations of Reasoning Models via the Lens of Problem Complexity“ that you can find here (https://ml-site.cdn-apple.com/papers/the-illusion-of-thinking.pdf).

“Can ‘reasoning’ models reason? Can they solve problems they haven’t been trained on? No.”

Что говорится в газете? Именно это я и утверждал: модели ИИ, даже самые передовые модели большого рассуждения (LRM), — это не более чем очень одаренные попугаи, по сути, не обладающие реальными способностями к рассуждению.

Они ни в малейшей степени не “умны”, по крайней мере, если вы понимаете, что интеллект подразумевает подлинное решение проблем, а не просто повторение того, что вам говорили раньше, не понимая этого.

Именно это и пыталась понять статья Apple: могут ли модели “рассуждений“ на самом деле рассуждать? Могут ли они решать проблемы, которым они не обучены, но которые обычно легко решаются с помощью их “знаний”? Ответ, как оказалось, однозначный “нет“.

Особенно ярким примером из статьи стала головоломка с переправой через реку: представьте, что трем людям и их трем агентам нужно пересечь реку на небольшой лодке, которая может перевозить только двух человек одновременно. В чем подвох? Человека никогда нельзя оставлять наедине с чужим агентом, и лодка не может пересечь границу пустой — кто-то всегда должен грести на ней обратно.

Именно такую логическую головоломку вы можете найти в детской книге-головоломке — придумайте правильную последовательность поездок, чтобы переправить всех через реку. Решение требует всего 11 шагов.

Оказалось, что эту простую головоломку не удалось решить с помощью сонета Клода 3.7, одного из самых продвинутых ИИ «рассуждения». Он даже не смог пройти 4-й ход, прежде чем сделал незаконные ходы и нарушил правила.

Однако тот же самый ИИ мог бы безупречно решить головоломку «Ханойская башня» с помощью 5 дисков — гораздо более сложная задача, требующая 31 идеального хода подряд.

Почему такая огромная разница? Исследователи Apple выяснили это: Ханойская башня - это классическая головоломка в области информатики, которая появляется по всему Интернету, поэтому во время обучения ИИ запомнил тысячи примеров. Но головоломка с переправой через реку с тремя людьми? Видимо, в сети это встречается слишком редко, чтобы ИИ мог запомнить закономерности.

Все это свидетельствует о том, что эти модели вообще не являются рассуждениями. По-настоящему рассуждающая система распознает, что обе головоломки предполагают один и тот же тип логического мышления (следуя правилам и ограничениям), просто с разными сценариями. Но поскольку ИИ так и не выучил наизусть схему переправы через реку, она была полностью утеряна.

Это тоже не был вопрос вычислений: исследователи дали моделям ИИ неограниченные бюджеты токенов для работы. Но самое странное то, что в головоломках или вопросах, которые они не могли решить, например, в головоломке с переправой через реку, модели на самом деле начинали думать меньше, а не больше; они использовали меньше жетонов и сдавались быстрее.

Человек, столкнувшийся с более сложной головоломкой, обычно тратил больше времени на ее обдумывание, но эти модели «рассуждения» делали наоборот: они, по сути, “понимали”, что им нечего повторять, поэтому они просто сдавались — противоположность тому, чего можно было бы ожидать от подлинного рассуждения.

Вывод: это действительно просто одаренные попугаи или невероятно сложные копипасты, если можно так выразиться.

Это имеет глубокие последствия для будущего ИИ, в котором мы все уверены. Что-то хорошее, что-то более тревожное.

Первое: нет, AGI не за горами. Это все шумиха. По правде говоря, мы все еще находимся на расстоянии световых лет.

Хорошая новость в том, что нам не нужно беспокоиться о том, что в ближайшее время появятся «повелители ИИ».

Плохая новость заключается в том, что потенциально у нас могут быть триллионы нерационально распределенного капитала.

Комментариев нет:

Отправить комментарий