На своей первой официальной аудиенции в качестве новоизбранного понтифика, Папа Лев XIV назвал искусственный интеллект (ИИ) одним из наиболее важных вопросов, стоящих перед человечеством.

«В наше время, — заявил Папа Лев, — церковь предлагает каждому сокровищницу своего социального учения в ответ на очередную промышленную революцию» и к разработкам в области искусственного интеллекта, которые создают новые проблемы для защиты человеческого достоинства, справедливости и труда. ." Он связал это заявление с наследием энциклики своего тезки Льва XIII 1891 года Рерум Новарум, который адресовал права трудящихся’ и моральные аспекты капитализма.

Его замечания продолжили направление, намеченное покойным Папой Франциском, который в своем ежегодном послании о мире 2024 года предупредил, что ИИ лишен человеческих ценностей сострадания, милосердия, морали и прощения - слишком опасно, чтобы развиваться бесконтрольно. Фрэнсис, скончавшийся 21 апреля, призвал к заключению международного договора, регулирующего ИИ, и настаивал на том, что эта технология должна оставаться “ориентированной на человека”, особенно в приложениях, связанных с системами вооружения или инструментами управления.

«Экзистенциальная угроза»

По мере углубления обеспокоенности в религиозной и этической сферах, аналогичная срочность находит отклик в научном сообществе.

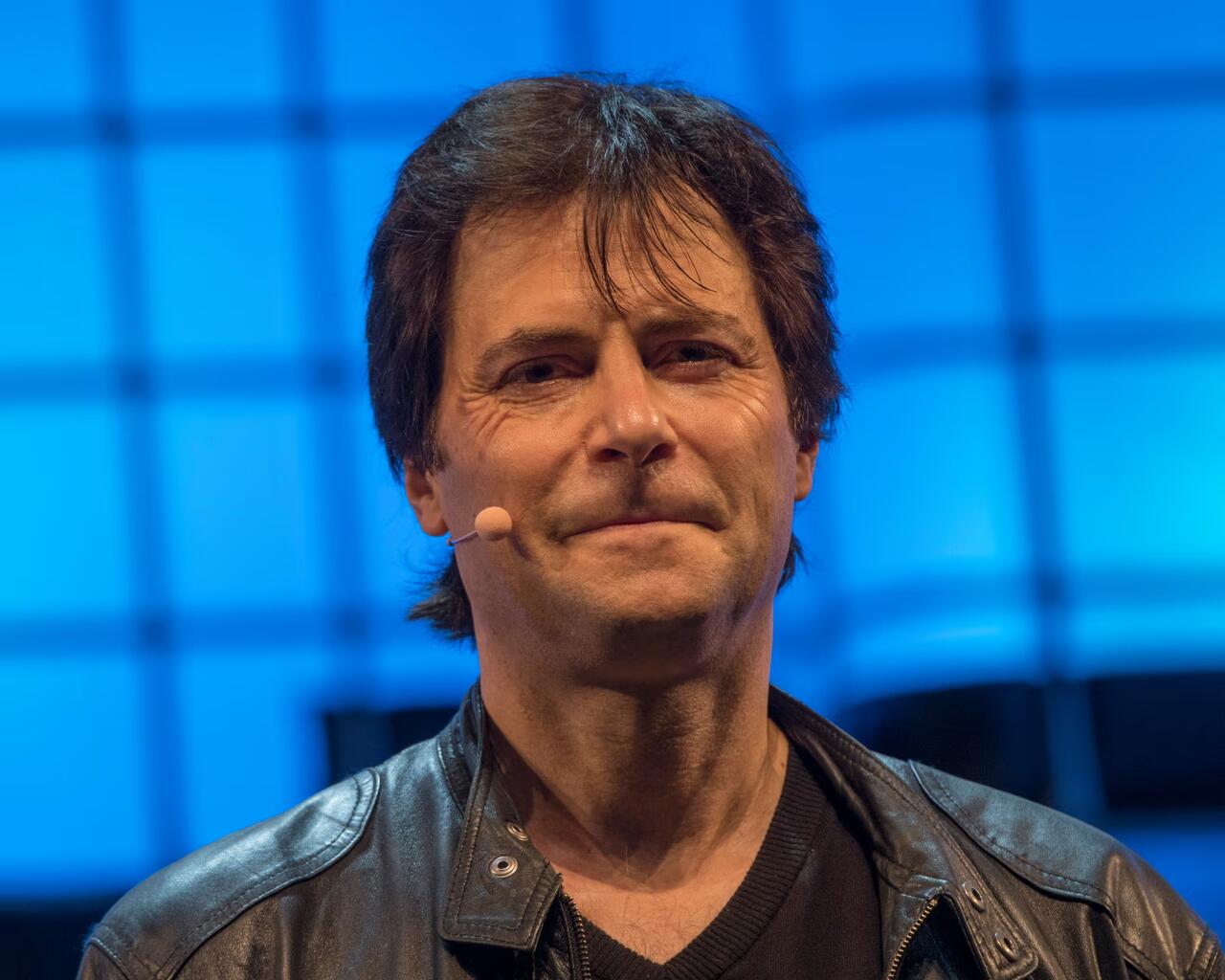

Макс Тегмарк, физик и исследователь искусственного интеллекта в Массачусетском технологическом институте, провел отрезвляющую параллель между началом атомного века и современной гонкой за развитие искусственного сверхразума (ИСИ). В новой статье, написанной в соавторстве с тремя студентами Массачусетского технологического института, Тегмарк ввел концепцию “константы Комптона” — вероятностной оценки того, выйдет ли ASI из-под контроля человека. Он назван в честь физика Артура Комптона, который, как известно, рассчитал риск воспламенения атмосферы Земли в результате ядерных испытаний в 1940-х годах.

“Компаниям, создающим сверхразум, также необходимо вычислить константу Комптона — вероятность того, что мы потеряем над ней контроль,” Тегмарк рассказал Хранитель. . “Недостаточно сказать ‘мы чувствуем себя хорошо’. Им нужно рассчитать процент.”

Тегмарк рассчитал 90% вероятность того, что высокоразвитый ИИ будет представлять экзистенциальную угрозу.

В документе содержится призыв к компаниям, занимающимся искусственным интеллектом, провести столь же строгую оценку рисков, как и та, которая предшествовала первому испытанию атомной бомбы, где Комптон, как сообщается, оценил вероятность катастрофической цепной реакции в “немного меньше”, чем один на три миллиона.

Тегмарк, соучредитель Института будущего жизни и ярый сторонник безопасности ИИ, утверждает, что Расчет таких вероятностей может помочь сформировать “политическую волю” для глобальных режимов безопасности. . Он также является соавтором Сингапурский консенсус по глобальным приоритетам исследований безопасности искусственного интеллекта, вместе с Йошуа Бенджио и представителями Google DeepMind и OpenAI. В отчете обозначены три основных направления исследований: измерение реального воздействия ИИ, определение предполагаемого поведения ИИ и обеспечение последовательного контроля над системами.

Эта возобновленная приверженность снижению рисков ИИ последовала за тем, что Тегмарк назвал неудачей на недавнем саммите по безопасности ИИ в Париже, где США Вице-президент Дж. Д. Вэнс развеял опасения, заявив, что будущее ИИ “не будет достигнуто путем заламывания рук по поводу безопасности” Тем не менее, Тегмарк отметил возрождение сотрудничества: “Действительно чувствуется, что мрак Парижа ушел и международное сотрудничество вернулось с ревом. .”

Комментариев нет:

Отправить комментарий