Автор: Майкл Т. Клэр, Consortium News/TomDispatch.com

Страшно представить себе мир, в котором машины, управляемые искусственным интеллектом (ИИ), систематически заменяют людей в большинстве деловых, промышленных и профессиональных функций. В конце концов, как предупреждали нас видные ученые-компьютерщики, управляемые ИИ системы склонны к критическим ошибкам и необъяснимым «галлюцинациям», что может привести к катастрофическим последствиям. Но есть еще более опасный сценарий, который можно вообразить из-за распространения сверхразумных машин: возможность того, что эти нечеловеческие существа могут в конечном итоге сражаться друг с другом, уничтожая в процессе всю человеческую жизнь.

Представление о том, что сверхинтеллектуальные компьютеры могут выйти из-под контроля и убить людей, конечно же, уже давно является одним из основных элементов массовой культуры. В пророческом фильме 1983 года «Военные игры» суперкомпьютер, известный как WOPR (от «Ответ на план военных операций» и, что неудивительно, произносится как «громадный»), едва не спровоцировал катастрофическую ядерную войну между Соединенными Штатами и Советским Союзом, прежде чем был выведен из строя подростком. хакер (играет Мэтью Бродерик). Франшиза фильма « Терминатор », начиная с оригинального фильма 1984 года, аналогичным образом представляла самосознательный суперкомпьютер под названием «Скайнет», который, как и WOPR, был разработан для управления ядерным оружием США, но вместо этого предпочитает уничтожить человечество, рассматривая нас как угрозу. к его существованию. Хотя когда-то концепция суперкомпьютеров, убивающих людей, была ограничена областью научной фантастики, теперь она стала вполне реальной возможностью в очень реальном мире ближайшего будущего .

В дополнение к разработке широкого спектра « автономных » или роботизированных боевых устройств крупные военные державы также спешат создать автоматизированные системы принятия решений на поле боя, или то, что можно было бы назвать « роботами-генералами ». В войнах не столь отдаленного будущего такие системы с искусственным интеллектом можно будет использовать для отдачи боевых приказов американским солдатам, диктуя, где, когда и как им убивать вражеские войска или принимать на себя огонь противника. В некоторых сценариях принимающие решения роботы могут даже в конечном итоге осуществлять контроль над атомным оружием Америки, потенциально позволяя им разжечь ядерную войну, которая приведет к гибели человечества.

Теперь сделайте вдох на мгновение. Установка такой системы управления и контроля (C2) на базе искусственного интеллекта может показаться отдаленной возможностью. Тем не менее, Министерство обороны США усердно работает над систематической и все более быстрой разработкой необходимого аппаратного и программного обеспечения . Например, в своем бюджете на 2023 год ВВС запросили 231 миллион долларов на разработку Advanced Battlefield Management System (ABMS), сложной сети датчиков и компьютеров с искусственным интеллектом, предназначенных для сбора и интерпретации данных об операциях противника и предоставления пилотам и сухопутные войска с меню оптимальных вариантов атаки. По мере развития технологий система будет способна отправки инструкций «огонь» непосредственно «стрелкам», в значительной степени минуя человеческий контроль .

«Инструмент обмена данными между машинами, который предоставляет возможности для сдерживания, демонстрации силы на начальном этапе или раннего вступления в бой», — сказал Уилл Роупер, помощник министра ВВС по закупкам, технологиям. и логистика, описали систему ABMS в интервью 2020 года. Предполагая, что «нам действительно нужно изменить название» по мере развития системы, Роупер добавил: «Я думаю, что Скайнет отсутствует, хотя мне бы очень хотелось сделать это как научно-фантастическую вещь. Я просто не думаю, что мы можем пойти туда».

И хотя он не может туда пойти, остальные из нас действительно могут пойти именно туда.

Имейте в виду, это только начало. Фактически, ABMS ВВС призвана стать ядром более крупного созвездия датчиков и компьютеров, которые свяжут все боевые силы США . »). «JADC2 призван позволить командирам принимать более обоснованные решения, собирая данные с многочисленных датчиков, обрабатывая данные с использованием алгоритмов искусственного интеллекта для идентификации целей, а затем рекомендуя оптимальное оружие… для поражения цели», — сообщила Исследовательская служба Конгресса в 2022 году .

ИИ и ядерный триггер

Первоначально JADC2 будет предназначен для координации боевых действий между «обычными» или неядерными американскими силами. Однако в конечном итоге ожидается, что он будет связан с ядерными системами управления и связи Пентагона (NC3), что потенциально даст компьютерам значительный контроль над использованием американского ядерного арсенала. «JADC2 и NC3 переплетены», — указал в интервью 2020 года генерал Джон Э. Хайтен, заместитель председателя Объединенного комитета начальников штабов . В результате он добавил на типичном пентагонском языке: «NC3 должен проинформировать JADC2, а JADC2 должен проинформировать NC3».

Не требуется большого воображения, чтобы представить себе время в недалеком будущем, когда какой-либо кризис — скажем, военное столкновение США и Китая в Южно-Китайском море или вблизи Тайваня — вызовет еще более ожесточенные бои между противоборствующими воздушными силами. и военно-морские силы. Представьте себе, что JADC2 отдает приказ об интенсивной бомбардировке вражеских баз и командных систем в самом Китае, вызывая ответные атаки на объекты США, и молниеносное решение JADC2 нанести ответный удар тактическим ядерным оружием, разжигая долгожданную ядерную катастрофу.

Возможность того, что кошмарные сценарии такого рода могут привести к случайному или непреднамеренному началу ядерной войны, уже давно беспокоит аналитиков в сообществе по контролю над вооружениями. Но растущая автоматизация военных систем оперативного управления вызвала тревогу не только у них, но и у высокопоставленных чиновников национальной безопасности.

Еще в 2019 году, когда я допросил генерал-лейтенанта Джека Шанахана, тогдашнего директора Объединенного центра искусственного интеллекта Пентагона, о такой рискованной возможности, он ответил: «Вы не найдете более сильного сторонника интеграции возможностей ИИ в полном объеме в Департамент обороны, но есть одна область, где я делаю паузу, и она связана с командованием и контролем ядерных вооружений ». Это «это окончательное человеческое решение, которое необходимо принять», и поэтому «мы должны быть очень осторожны». Учитывая «незрелость» технологии, добавил он, нам нужно «много времени для тестирования и оценки [перед применением ИИ в NC3]».

В последующие годы, несмотря на такие предупреждения, Пентагон стремительно развивал автоматизированные системы C2. В своем бюджете на 2024 год Министерство обороны запросило 1,4 миллиарда долларов для JADC2 , чтобы «преобразовать боевые возможности, предоставляя информационное преимущество со скоростью актуальности во всех областях и партнерах». О-о! А затем он запросил еще 1,8 миллиарда долларов на другие виды исследований ИИ, связанных с военными.

Чиновники Пентагона признают, что пройдет некоторое время, прежде чем роботы-генералы будут командовать огромным количеством американских войск (и автономных вооружений) в бою, но они уже запустили несколько проектов, предназначенных для проверки и совершенствования именно таких связей. Одним из примеров является армейский проект «Конвергенция»., включая серию полевых учений, предназначенных для проверки систем компонентов ABMS и JADC2. Например, в ходе испытаний, проведенных в августе 2020 года на испытательном полигоне Юма в Аризоне, армия использовала различные воздушные и наземные датчики для отслеживания смоделированных сил противника, а затем обрабатывала эти данные с помощью компьютеров с искусственным интеллектом на Объединенной базе Льюис. Маккорд в штате Вашингтон. Эти компьютеры, в свою очередь, давали указания по стрельбе наземной артиллерии в Юме. «Вся эта последовательность предположительно была выполнена в течение 20 секунд», — позже сообщила Исследовательская служба Конгресса .

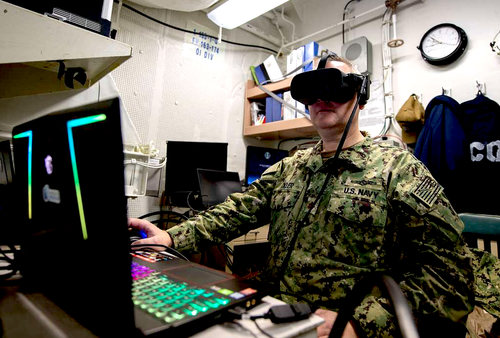

Меньше известно об эквиваленте искусственного интеллекта ВМФ «Проект Overmatch», поскольку многие аспекты его программирования держатся в секрете. По словам адмирала Майкла Гилдэя, начальника военно-морских операций, Overmatch предназначена « для того, чтобы флот, который кишит морем, наносил синхронизированные смертоносные и нелетальные эффекты с ближнего и дальнего расстояния, со всех осей и из каждой области». О проекте мало что известно.

«Быстрые войны» и вымирание человечества

Несмотря на всю секретность, окружающую эти проекты, вы можете думать о ABMS, JADC2, Convergence и Overmatch как о строительных блоках будущей мегасети суперкомпьютеров, подобной Скайнету, предназначенной для управления всеми силами США, включая их ядерные, в вооруженных силах. бой. Чем больше Пентагон будет двигаться в этом направлении, тем ближе мы подойдем к моменту, когда ИИ будет обладать жизненной силой над всеми американскими солдатами, а также над противоборствующими силами и любыми гражданскими лицами, попавшими под перекрестный огонь.

Такая перспектива должна быть достаточной причиной для беспокойства. Для начала рассмотрим риск ошибок и просчетов алгоритмов, лежащих в основе таких систем. Как предупреждали нас ведущие ученые-компьютерщики, эти алгоритмы способны совершать удивительно необъяснимые ошибки и, если использовать современный термин ИИ, «галлюцинации» — то есть кажущиеся разумными результаты, которые являются полностью иллюзорными . В сложившихся обстоятельствах нетрудно представить, что такие компьютеры «галлюцинируют» неминуемое нападение противника и развязывают войну, которой в противном случае можно было бы избежать.

И это не самая страшная из опасностей. В конце концов, существует очевидная вероятность того, что противники Америки аналогичным образом вооружат свои силы роботами-генералами. Другими словами, будущие войны, скорее всего, будут вестись одним набором систем ИИ против другого, обе связаны с ядерным оружием, с совершенно непредсказуемыми — но потенциально катастрофическими — результатами.

Не так много известно (по крайней мере, из открытых источников) об усилиях России и Китая по автоматизации своих систем военного управления, но считается, что обе страны разрабатывают сети, сопоставимые с JADC2 Пентагона. Фактически, еще в 2014 году Россия открыла в Москве Национальный центр управления обороной (NDCC), централизованный командный пункт для оценки глобальных угроз и инициирования любых военных действий, которые будут сочтены необходимыми, будь то неядерного или ядерного характера. Как и JADC2, NDCC предназначен для сбора информации о передвижениях противника из нескольких источников и предоставления старшим офицерам рекомендаций по возможным ответным действиям.

Говорят, что Китай занимается еще более сложным, хотя и похожим, предприятием под рубрикой «Многодоменная высокоточная война» (MDPW). Согласно отчету Пентагона о военных разработках Китая за 2022 год, его вооруженные силы, Народно-освободительная армия Китая, обучаются и оснащаются для использования сенсоров с поддержкой ИИ и компьютерных сетей для «быстрого выявления ключевых уязвимостей в операционной системе США, а затем объединения совместных сил по всему миру». домены для нанесения точечных ударов по этим уязвимостям».

Представьте себе будущую войну между США и Россией или Китаем (или обоими), в которой JADC2 командует всеми силами США, в то время как российский NDCC и китайский MDPW командуют силами этих стран . Учтите также, что все три системы могут испытывать ошибки и галлюцинации . Насколько безопасны будут люди, когда генералы-роботы решат, что пришло время «выиграть» войну, нанеся ядерный удар своим врагам?

Если это кажется вам диковинным сценарием, подумайте еще раз, по крайней мере, согласно руководству Комиссии национальной безопасности по искусственному интеллекту, предприятия, уполномоченного Конгрессом, которое возглавляли Эрик Шмидт, бывший глава Google, и Роберт Уорк, бывший заместитель госсекретаря. защиты. «Хотя Комиссия считает, что должным образом спроектированные, испытанные и используемые автономные системы вооружения с искусственным интеллектом принесут существенную военную и даже гуманитарную пользу, неконтролируемое глобальное использование таких систем потенциально может привести к непреднамеренной эскалации конфликта и кризисной нестабильности», — говорится в заявлении . в своем Заключительном отчете. Такие опасности могут возникнуть, говорится в заявлении, «из-за сложных и непроверенных сложностей взаимодействия между ИИ и автономными системами вооружения на поле боя» — то есть когда ИИ борется с ИИ.

Хотя это может показаться экстремальным сценарием, вполне возможно, что противоборствующие системы искусственного интеллекта могут спровоцировать катастрофическую «мгновенную войну» — военный эквивалент «мгновенного краха» на Уолл-стрит, когда огромные транзакции с помощью сверхсложных торговых алгоритмов вызывают панические продажи перед люди-операторы могут восстановить порядок. Во время печально известного «Внезапного обвала» 6 мая 2010 года компьютеризированная торговля ускорила падение стоимости фондового рынка на 10%. В соответствии с Пол Шарре из Центра новой американской безопасности, который первым изучил это явление, «военный эквивалент таких кризисов» на Уолл-стрит возникает, когда автоматизированные системы управления противоборствующими силами «попадают в ловушку каскада эскалации столкновений». В такой ситуации, отметил он, «автономное оружие может мгновенно привести к случайной гибели и разрушениям в катастрофических масштабах».

В настоящее время практически отсутствуют меры по предотвращению подобной катастрофы в будущем и даже не ведутся переговоры между крупными державами о выработке таких мер. Тем не менее, как отметила Комиссия национальной безопасности по искусственному интеллекту, такие меры кризисного контроля срочно необходимы для интеграции «автоматических растяжек эскалации» в такие системы, «которые предотвратили бы автоматическую эскалацию конфликта». В противном случае вполне возможна какая-то катастрофическая версия Третьей мировой войны. Учитывая опасную незрелость такой технологии и нежелание Пекина, Москвы и Вашингтона накладывать какие-либо ограничения на использование ИИ в качестве оружия, день, когда машины смогут решить нас уничтожить, может наступить гораздо раньше, чем мы предполагаем, и вымирание человечества может быть побочный ущерб от такой будущей войны.

Комментариев нет:

Отправить комментарий